Nachtrag:

Twitter hat die Nutzeroberfläche und die Konfigurierung verändert, weshalb ich eine neue Anleitung erstellt habe, siehe Twitter-Tweets in eine Webseite einbauen.

Twitter hat die Nutzeroberfläche und die Konfigurierung verändert, weshalb ich eine neue Anleitung erstellt habe, siehe Twitter-Tweets in eine Webseite einbauen.

|

| Die Twitter-Box lässt sich nach Wunsch konfigurieren und kann in jede Webseite eingebaut werden. Ich nutze sie auf meiner Portalseite tinto.de, um dort meine neuesten Tweets anzuzeigen. |

Eigentlich gibt es die Möglichkeit, eine Twitter-Box mit öffentlichen Tweets in die Website einzubinden, schon seit Langem, doch war die Funktion etwas versteckt. Jetzt wurde der Widget-Code von Twitter umgestellt, der Widget-Konfigurator erweitert und leichter auffindbar gemacht.

Twitter auf Website einbinden - Anleitung

So generieren Sie Ihr Widget:- Gehen Sie auf die Twitter-Homepage

- Loggen Sie sich mit ID und Passwort ein.

- Klicken Sie auf Ihr Porträtbild in der Symbolleiste oben rechts und wählen Sie in der Dropdown-Liste Einstellungen und Datenschutz.

- Auf der Seite Account wählen Sie in der Navigation auf der linken Seite Widgets.

- Klicken Sie auf Neu erstellen.

- Nun öffnet sich der Widgets-Konfigurator.

Widgets-Konfigurator für die Konfigurierung einer Benutzer-Timeline Über die Reiter unterhalb von Wähle eine Timeline-Quelle können Sie aussuchen, welche Art von Tweets Ihre Twitter-Box zeigen soll: - Benutzer Timeline

Tweets eines öffentlichen Accounts - Gefällt mir

Tweets, die Sie als Favoriten gekennzeichnet haben - Liste

Tweets einer Liste, die Sie zuvor angelegt und denen Sie öffentliche Twitter-Accounts zugeordnet haben - Suchen

Tweets, die mit einem definierten Hashtag-Begriff, z. B. #garten, gekennzeichnet wurden - Sammlung

Tweent einer Sammlung, die Sie zuvor angelegt haben. - Die Konfigurierung ist weitgehend selbsterklärend.

Beispiel Benutzer-Timeline: - Wählen Sie den Reiter Benutzer Timeline.

- Auf der linken Seite können Sie Ihr Widget nun konfigurieren, auf der rechten Seite wird währenddessen eine Vorschau angezeigt.

- Bei Nutzername können Sie Ihren eigenen oder einen anderen öffentlichen Twitter-Account angeben.

- Bei Optionen können Sie wählen, ob Antworten auf Tweets auch eingeblendet und ob Bilder angezeigt werden sollen.

- Bei Höhe geben Sie einen Wert von mindestens 200 ein, wenn Sie nicht den vorgegebenen Wert von 600 px beibehalten wollen. Die Breite muss nicht angegeben werden, da Twitter die Breite der Box automatisch an die Umgebung anpasst - sie ist jedoch mindestens 180 px breit.

- Bei Thema können Sie zwischen Hell und Dunkel wählen.

- Bei Linkfarbe können Sie eine Farbe auswählen, nachdem Sie in das Feld geklickt haben, und diese speichern.

- Twitter für mich nicht anpassen aktivieren Sie mit einem Häkchen, wenn Sie nicht möchten, dass Ihnen Twitter Tweets einblendet aufgrund von Informationen, die der Dienst über Ihre Interessen und Verhalten gespeichert hat.

- Klicken Sie auf Widget erstellen oder später beim Bearbeiten Änderungen speichern.

Die Eingaben werden nun auf einem Twitter-Server gespeichert und rechts unten im Code-Feld Ihr Widget-Code eingeblendet. - Kopieren Sie den Code und fügen Sie ihn an der Stelle, an der Sie Twitter in die Website einbinden wollen, in den HTML-Code Ihrer Website/Homepage oder Ihres Blogs ein.

Tipp:

Zusätzliche Anpassungsmöglichkeiten ("Client Side Options") werden auf der Seite für Twitter Entwickler beschrieben (Englisch).

Twitter auf Website einbinden - Anwendungsbeispiele

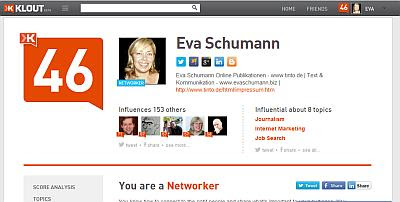

Ich habe eine Twitter-Box mit meinen letzten Tweets auf meiner tinto.de-Einstiegsseite und im Media Newsroom von evaschumann.biz eingebunden. Ob das auch bei Ihnen Sinn macht, hängt von der persönlichen Nutzung und vom Kommunikationskonzept ab.

Anzeige

Ich verwende die verschiedenen Social-Media-Plattformen zu unterschiedlichen Zwecken:

Anzeige

Ich verwende die verschiedenen Social-Media-Plattformen zu unterschiedlichen Zwecken:

- Zum Diskutieren bevorzuge ich die Kommentarfunktionen von Blogs sowie die Kommunikationsmöglichkeiten bei Facebook und Googleplus.

- In meiner Twitter-Timeline stelle ich vorwiegend neue Blogartikel und Informationswebseiten aus meinem eigenen "Internetreich" vor. Nur manchmal teile ich auch besonders Interessantes aus meinem Netzwerk auf Twitter - allerdings nur dann, wenn ich meine, dass diese Tweets nicht nur meine Twitter-Follower, sondern auch meine Webseiten-/Blogbesucher interessieren könnten, denn wie bereits erwähnt: Ich habe Twitter auf meiner tinto.de-Einstiegsseite und im Social Media Newsroom von evaschumann.biz eingebunden. So haben auch meine Webseiten- und Blogbesucher eine komfortable Möglichkeit, sich anhand der letzten Tweets über Neues in meinen Internetprojekten zu informieren.

Nutzt/nutzen Sie die

Kommentarfunktion und fügt eure/Ihre Erfahrungen hinzu. Wenn der Blogbeitrag

euch/Sie inspiriert hat, abonniert/abonnieren Sie den Feed oder per E-Mail.

Das könnte Sie auch interessieren:

- Parfüms & Co. blind, ohne Ausprobieren, online kaufen? So fiel mein Selbsttest aus. (Verbrauchermeinung)

- Der Corporate Blog als Teil der

Unternehmensstrategie

- Letzte Blogartikel, Foren- und Social-Media-Beiträge als Linklisten in eine Website einbinden

- Bezahlte Blogartikel - Sponsor Posts

und Sponsored Posts

Sie suchen Werbeplatz in diesem Blog oder eine

Technische Redakteurin/Autorin/Texterin zu Software-, Informatik- oder

Internetthemen für Ihre Website, ein Buchprojekt, ein Kundenmagazin o. Ä.? Schreiben Sie mir!

Um es gleich vorwegzunehmen:

Um es gleich vorwegzunehmen: